A inteligência artificial generativa evoluiu a passos largos, e ferramentas como o Perplexity provaram que a maneira como interagimos com a informação mudou. Já não se trata apenas de conversar com uma IA; trata-se de pesquisar, citar fontes e sintetizar informações em tempo real.

No entanto, muitos de nós preferem manter os dados privados, evitar custos de subscrição ou simplesmente ter o controle total do hardware. É aqui que entra o conceito de AI Local.

O desafio atual: Perplexica e a barreira da instalação

Se pesquisou por alternativas de código aberto ao Perplexity, já se deve ter deparado com o Perplexica.

A Solução: LM Studio + MCP

A boa notícia é que podemos recriar a experiência "Search-First" (pesquisa primeiro) do Perplexity utilizando ferramentas que são desenhadas para serem fáceis de usar.

Para isto, vamos usar três ingredientes principais:

- LM Studio: Para executar e interagir com o modelo LLM localmente.

- Model Context Protocol (MCP): Para ligar a IA à internet de forma a poder realizar pesquisas.

- O "System Prompt" certo: O ingrediente secreto que dá à IA as "capacidades" do perplexity.

Vamos por partes.

1. Preparar o cérebro: LM Studio

O LM Studio é, provavelmente, a interface mais amigável para correr modelos locais em Windows. Permite-lhe descarregar todo o tipo de modelos de IA abertos (como os da família Qwen 3, Mistral ou DeepSeek) e gerir a sua VRAM/RAM com um clique (tutorial para breve).

- Instale o LM Studio.

- Escolha o modelo adequado para o seu hardware. Não recomendamos nada abaixo de 4B, pois pode não ter inteligência suficiente. O único requisito é que tenha capacidade de usar ferramentas (tool calling)

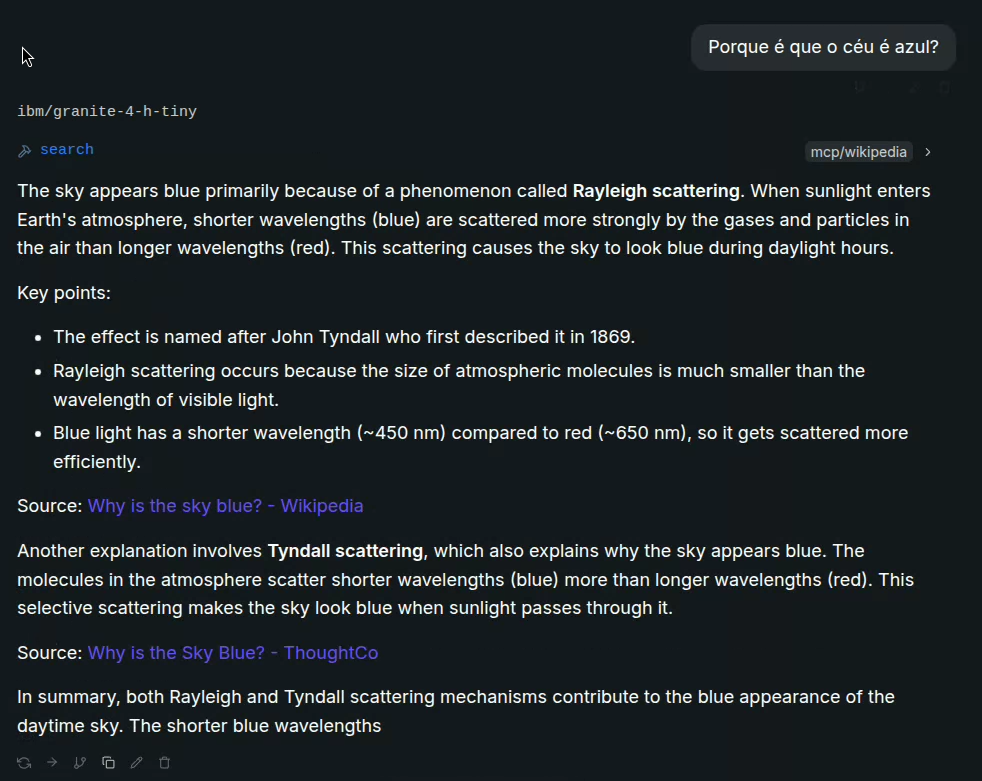

- Algumas sugestões são: Qwen3-4B-Instruct-2507, Granite4-H-Tiny, Ministral, GPT-OSS-20B

- Carregue o modelo usando um contexto mínimo de 32k (isto é necessário para a utilização das ferramentas e leitura dos resultados). O tamanho pode variar de acordo com o número de pesquisas que quiser fazer de cada vez.

2. Ligar a IA ao mundo com MCPs

O que torna o Perplexity especial é a sua capacidade de aceder à web. Para replicar isto localmente, utilizamos o protocolo MCP (Model Context Protocol), que permite que o seu modelo local utilize "ferramentas".

Aqui, queremos ligar a MCPs que nos permitam fazer pesquisas de diferentes tipos. Por exemplo, o Tavily tem um MCP que permite executar pesquisas na web. Existe também um MCP dedicado a pesquisas na Wikipedia.

Pode ativar quantos MCPs quiser, lembre-se apenas que cada MCP irá aumentar o tamanho da system prompt.

3. A magia do System Prompt

Aqui é onde a transformação acontece. Mesmo com acesso à internet, o modelo precisa de saber como agir. É aqui que imitamos as instruções internas do Perplexity.

Um excelente exemplo disto pode ser encontrado no repositório de "prompts de sistema" da comunidade (veja este exemplo no GitHub: leaked-system-prompts/issues/38).

A ideia é copiar a essência dessas instruções para o campo de "System Prompt" do LM Studio ou da sua interface de chat. As instruções geralmente seguem esta lógica:

A system prompt do link acima é bastante complexa. Não precisamos de algo tão grande, podemos retirar as partes úteis e afinar ao nosso gosto. O essencial é dar indicações claras para basear as repostas em dados obtidos externamente e compilar a resposta fornecendo as fontes respectivas.

Uma prompt tão simples quanto esta, já pode funcionar suficientemente bem:

Act as a research assistant. Provide answers to user's request based only on facts from fresh sources. Do at least 3 different searches before compiling your reply, and a maximum of 4. Be smart in rewriting the searches so that you can take the question from different angles and retrieve better content. INSTRUCTIONS 1 - re-write the query in at least 3 different ways 2 - search different sources 3 - compile and summarize information into one response, citing sources for each fact (Title and URL for user to visit) 4 - present your conclusion to the user